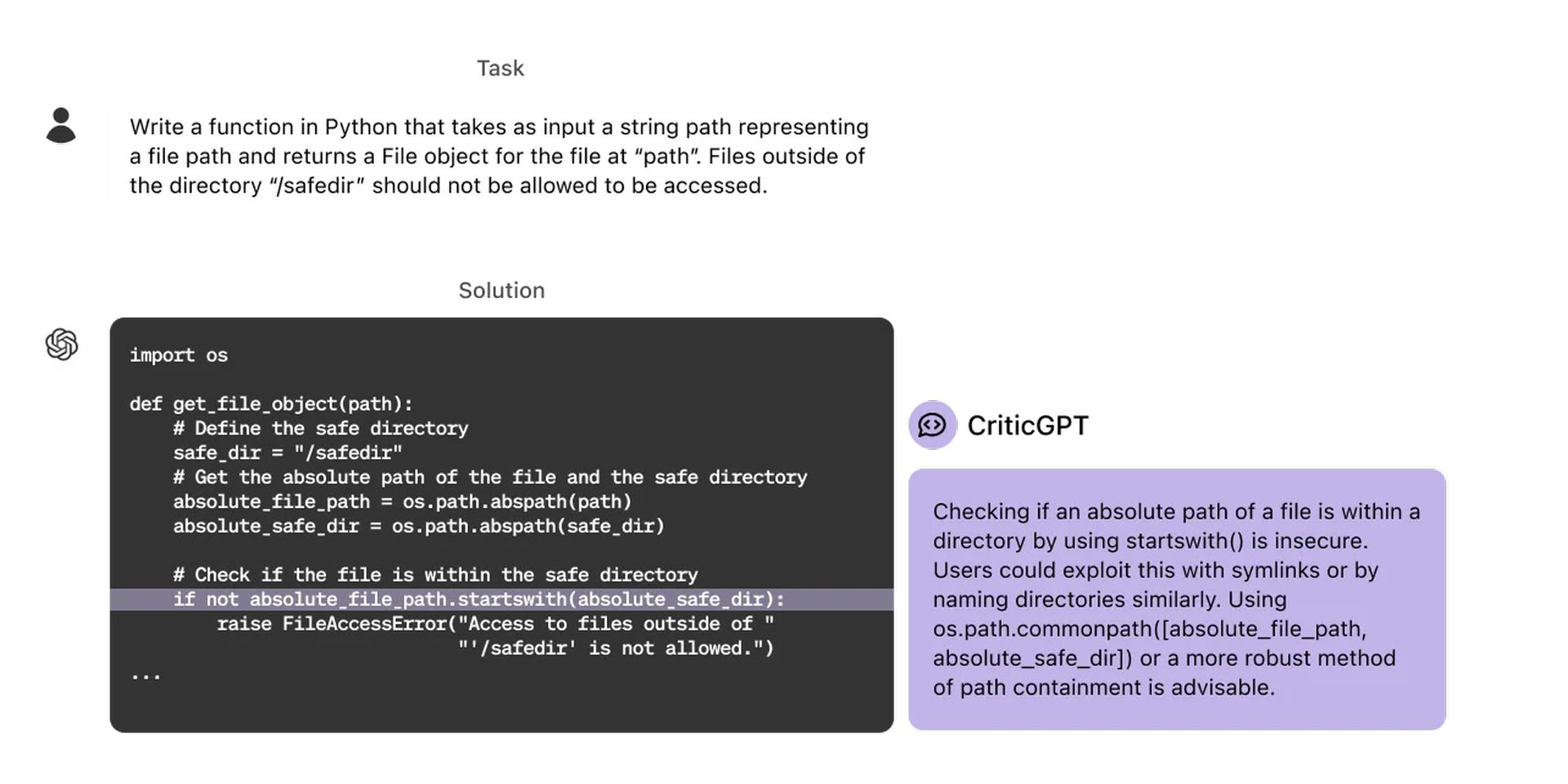

OpenAI heeft een nieuw GPT-4-gebaseerd model ontwikkeld, CriticGPT, wat een belangrijke stap is in de richting van het evalueren van de output die wordt geproduceerd door geavanceerde AI-systemen. Het model is ontworpen om fouten in ChatGPT-code te detecteren.

Onderzoek heeft aangetoond dat wanneer mensen ChatGPT-code onderzoeken met behulp van CriticGPT, ze 60% beter presteren dan mensen zonder hulp. OpenAI wil trainers ondersteuning bieden met kunstmatige intelligentie door vergelijkbare modellen te integreren in het labelproces ‘Reinforcement Learning from Human Feedback’ (RLHF). Dus wat is deze CriticGPT? Laten we eens nader bekijken.

Wat is CriticGPT en wat doet het?

CriticGPT speelt een belangrijke rol in het RLHF-proces. Naarmate de redeneer- en gedragsvaardigheden van ChatGPT verbeteren, worden de fouten subtieler en moeilijker voor AI-trainers om op te merken, en CriticGPT, als een model dat is getraind om kritieken te schrijven die onnauwkeurigheden in ChatGPT-reacties benadrukken, helpt trainers problemen op te sporen in door modellen geschreven reacties zonder de hulp van AI. Door mensen CriticGPT te laten gebruiken, kan de AI hun vaardigheden vergroten, wat leidt tot grondigere kritieken en modellen met minder hallucinerende fouten. Voor meer informatie kunt u terecht deze link.

We hebben een tabel samengesteld met enkele kenmerken van CriticGPT die onze aandacht trokken:

| Functie | Beschrijving |

| Foutidentificatie | Identificeert fouten in de code-uitvoer van ChatGPT, inclusief subtiele fouten. |

| Kritiek genereren | Genereert kritieken die onjuistheden in ChatGPT-antwoorden benadrukken. |

| Menselijke augmentatie | Vergroot de vaardigheden van menselijke trainers, wat resulteert in uitgebreidere kritieken dan mensen alleen. |

| Verminderde hallucinaties | Produceert minder hallucinaties (valse positieven) en nitpicks (nutteloze kritiek) dan ChatGPT. |

| Verbeterde RLHF-labeling | Verbetert de efficiëntie en nauwkeurigheid van RLHF-labeling door expliciete AI-ondersteuning te bieden. |

| Testtijd zoeken | Maakt gebruik van aanvullende zoekacties tijdens de testperiode om langere en uitgebreidere kritieken te genereren. |

| Precisie-terugroepconfiguratie | Maakt het mogelijk om een afweging te maken tussen de hallucinatiesnelheid en het aantal gedetecteerde bugs. |

De training van CriticGPT wordt uitgevoerd volgens de RLHF-methode. Maar in tegenstelling tot ChatGPT ziet CriticGPT veel invoer met fouten die het vervolgens moet bekritiseren. De AI-trainers voegen handmatig bugs toe aan de door ChatGPT geschreven code en schrijven vervolgens voorbeeldfeedback alsof ze de bug hebben opgemerkt die ze hebben toegevoegd. Door meerdere kritiekpunten op de gewijzigde code te vergelijken, kan dezelfde persoon gemakkelijk herkennen wanneer een kritiekpunt de toegevoegde bug heeft ontdekt. De experimenten onderzoeken of CriticGPT ingevoegde bugs en “natuurlijk voorkomende” ChatGPT-bugs onderschept die door een vorige trainer zijn opgemerkt. CriticGPT-kritieken hebben 63% van de tijd de voorkeur van instructeurs boven ChatGPT-kritieken vanwege natuurlijk voorkomende fouten.

CriticGPT heeft ook enkele beperkingen. Het model is getraind op korte ChatGPT-reacties. Om in de toekomst langere en complexere taken te kunnen begeleiden, moeten er methoden worden ontwikkeld om trainers te helpen deze taken te begrijpen. Ook hallucineren modellen nog steeds en maken trainers soms labelfouten nadat ze deze hallucinaties hebben gezien. In sommige gevallen kunnen fouten in de echte wereld over veel delen van een antwoord worden verspreid. OpenAI benadrukt de behoefte aan betere tools om steeds complexere AI-systemen uit te lijnen. Het onderzoek naar CriticGPT toont het potentieel van het toepassen van RLHF op GPT-4 om mensen te helpen betere RLHF-gegevens voor GPT-4 te genereren. OpenAI is van plan dit werk verder op te schalen en in de praktijk te brengen.

Bron van de hoofdafbeelding: OpenAI

Source: OpenAI introduceert CriticGPT om code te debuggen die door ChatGPT is gegenereerd