Technologische vooruitgang blijft het landschap van cyberbeveiliging hervormen, waarbij zowel nieuwe kansen als onvoorziene risico’s worden geïntroduceerd. Een team onderzoekers afkomstig van Britse universiteiten heeft een alarmerende exploit aangetoond die maakt gebruik van geluidsgolven om gevoelige gegevens van toetsaanslagen op het toetsenbord te stelen. De techniek, die gebruik maakt van een deep learning-model, pronkt een indrukwekkende nauwkeurigheid van 95%.

Het experiment was geworteld in de erkenning dat geluidsgolven die worden gegenereerd door toetsenbordaanslagen kunnen worden gebruikt onderscheiden de werkelijke toetsaanslagen. De onderzoekers begonnen aan een baanbrekende reis die liet zien de potentiële gevaren van op akoestiek gebaseerde aanvallen op gegevensbeveiliging.

De methodologie van het onderzoek

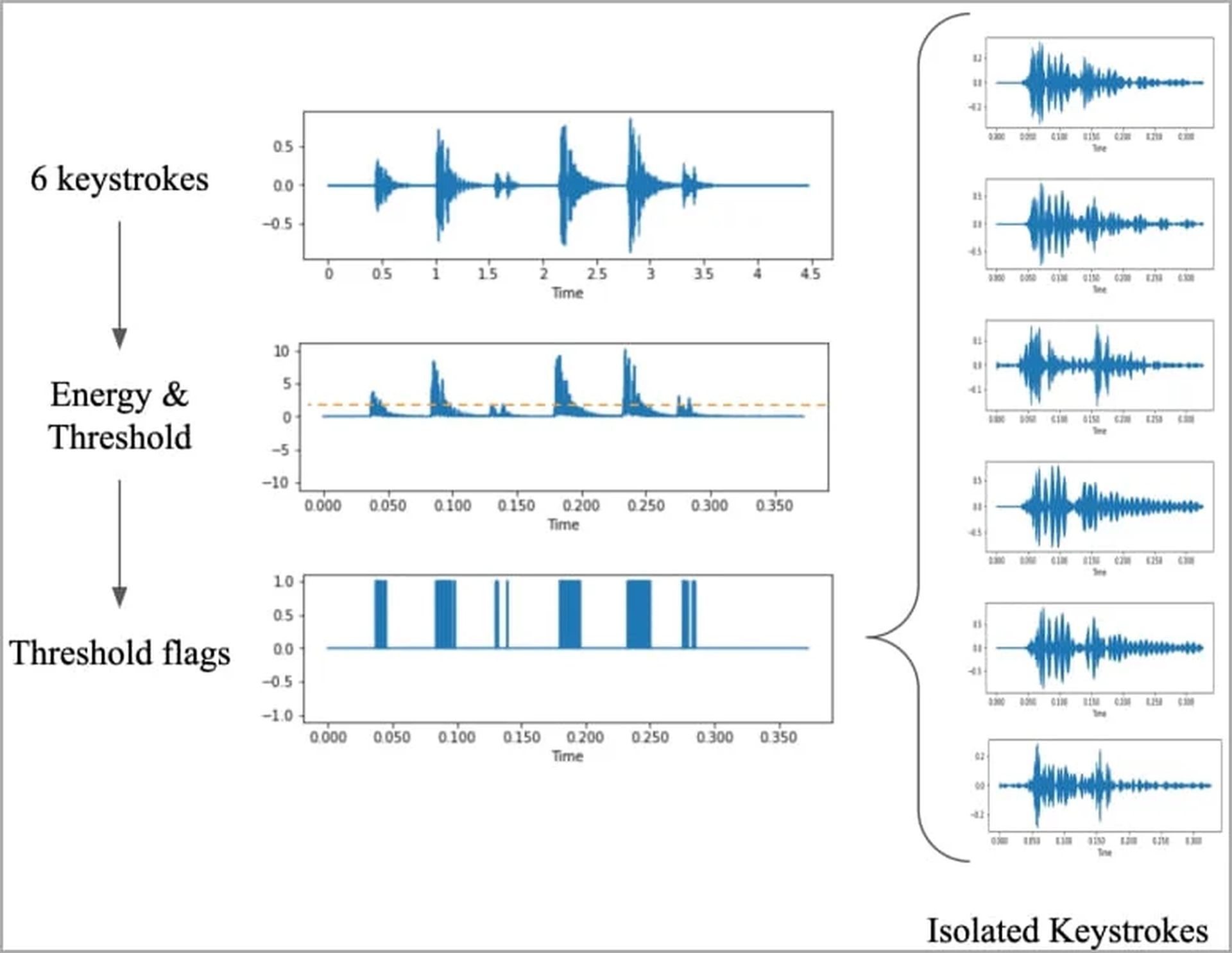

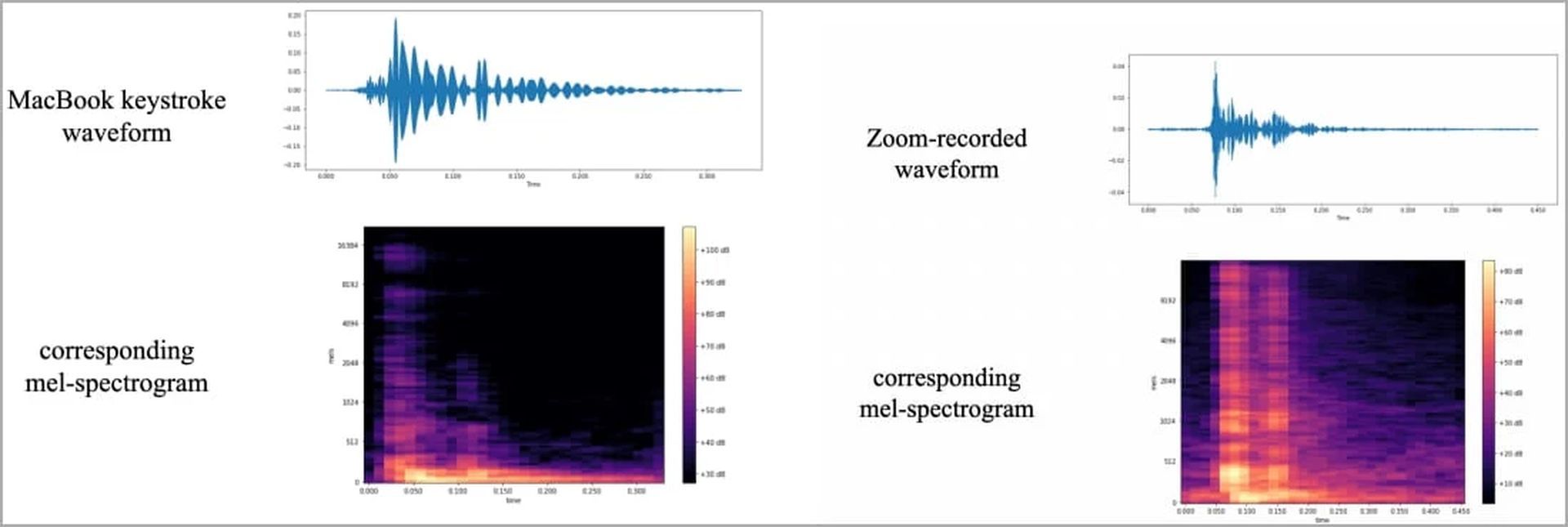

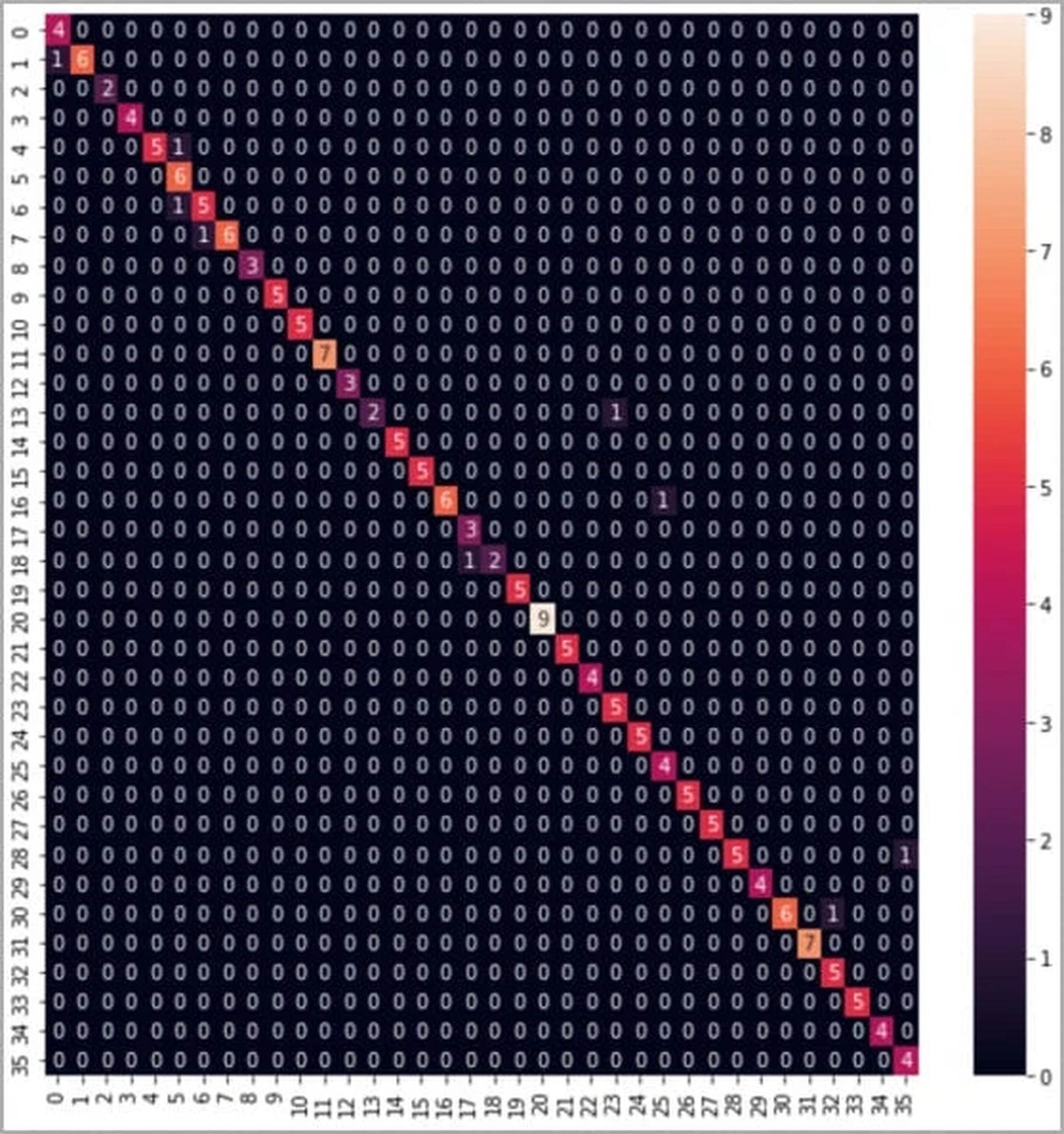

De kern van dit gedurfde wapenfeit ligt in het ingewikkelde wisselwerking tussen geluid, machine learning en data-extractie. Het onderzoeksteam gebruikte een reeks apparaten, van laptops naar smartphones, om de unieke geluidsprofielen van toetsaanslagen vast te leggen. Op een moderne MacBook Pro werden in totaal 36 toetsen 25 keer ingedrukt, terwijl de resulterende audiosignalen minutieus werden opgenomen.

De vastgelegde geluidsgegevens ondergaan een reeks verwerkingsstappen, uiteindelijk transformeren in visuele representaties zoals golfvormen en spectrogrammen. Deze visualisaties toonden onderscheidende variaties voor elke toetsaanslag, wat de weg vrijmaakte voor de ontwikkeling van een krachtige beeldclassificatie, genaamd ‘CoAtNet.’

De implicaties van de resultaten

De implicaties van dit onderzoek zijn diepgaand En verontrustend. Akoestische aanvallen traditionele veiligheidsmaatregelen omzeilen, exploiteren van de alomtegenwoordigheid van met microfoons uitgeruste apparaten om ongeoorloofde toegang te krijgen tot gevoelige informatie. Deze nieuwe aanpak is bijzonder verontrustend omdat het mogelijk persoonlijke gegevens kan blootleggen, waaronder wachtwoorden, gesprekken, berichten, En andere vertrouwelijke gegevens aan kwaadwillende actoren.

Traditionele side-channel-aanvallen vereisen doorgaans specifieke voorwaarden en zijn vaak daaraan gebonden gegevenssnelheid en afstandsbeperkingen. Akoestische aanvallen hebben echter een nieuw tijdperk ingeluid eenvoud En efficiëntie, profiteren van de overvloed aan apparaten die kunnen opnemen audio van hoge kwaliteit.

Mitigatiestrategieën

Aangezien dit baanbrekende onderzoek het cruciale belang van bescherming tegen akoestische aanvallen onderstreept, wordt het essentieel om mitigatiestrategieën te onderzoeken die gebruikers kunnen gebruiken om hun gegevens te beschermen.

- Veranderde typestijlen: De studie raadt gebruikers aan om hun typestijlen te veranderen om de akoestische signatuur van hun toetsaanslagen te verdoezelen.

- Willekeurige wachtwoorden: Het gebruik van gerandomiseerde wachtwoorden kan de patroonherkenningsmogelijkheden van op akoestiek gebaseerde aanvallers verstoren.

- Op software gebaseerde verdediging: Het gebruik van software die toetsaanslaggeluiden nabootst, witte ruis genereert of op software gebaseerde audiofilters gebruikt, kan mogelijk gegevensdiefstal tegengaan.

- Biometrische authenticatie: Het implementeren van biometrische authenticatiemethoden kan de beveiliging verbeteren door een extra laag identiteitsverificatie toe te voegen.

- Wachtwoordbeheerders: Vertrouwen op wachtwoordmanagers kan de noodzaak voor handmatige invoer van gevoelige informatie minimaliseren, waardoor de blootstelling aan akoestische aanvallen wordt verminderd.

In een wereld gekenmerkt door de snelle evolutie van technologie, beveiligingsproblemen blijven ook evolueren. Het onderzoek dient als een grimmige herinnering daaraan innovatieve methoden voor gegevensdiefstal komen voortdurend naar voren, een proactieve en adaptieve benadering van cyberbeveiliging vereist. Naarmate het digitale rijk vordert, moet ook onze verdediging tegen degenen die de kwetsbaarheden ervan willen uitbuiten, dat ook moeten doen.

Naast het onderzoek van Britse universiteiten zijn er steeds meer ontwikkelingen van AI-modellen die gericht zijn op gegevensdiefstal en hackpraktijken. Vorige maand ontstond er een AI-model gericht op gegevensdiefstal met de naam FraudGPT, evenals een AI-model genaamd WormgGPT, dat beweert geen enkele grens te kennen, waardoor illegale en onethische gesprekken mogelijk zijn.

Als je beter voorbereid wilt zijn op de voortdurende ontwikkelingen op het gebied van deep learning en AI-modellen, lees dan zeker ons artikel over hoe je op je hoede kunt zijn voor wijdverbreide ChatGPT-zwendel.

Uitgelichte afbeelding tegoed: Sergi Kabrera / Unsplash

Source: Onderzoekers ontwikkelen een deep learning-model dat gegevens steelt van toetsaanslagen