Nvidia brengt een revolutie teweeg in de wereld van kunstmatige intelligentie de recente lancering van de NVIDIA H200. Op dit geavanceerde platform is voortgebouwd de NVIDIA-hopper architectuur, beschikt over de krachtige NVIDIA H200 Tensor Core GPU, uitgerust met geavanceerd geheugen ontworpen om aan te pakken aanzienlijke gegevensbelasting voor generatieve AI en high-performance computing (HPC)-workloads.

architectuur, beschikt over de krachtige NVIDIA H200 Tensor Core GPU, uitgerust met geavanceerd geheugen ontworpen om aan te pakken aanzienlijke gegevensbelasting voor generatieve AI en high-performance computing (HPC)-workloads.

In dit artikel gaan we dieper in op de recente lancering en geven we zoveel mogelijk details over de nieuwe NVIDIA H200.

De kracht van NVIDIA H200

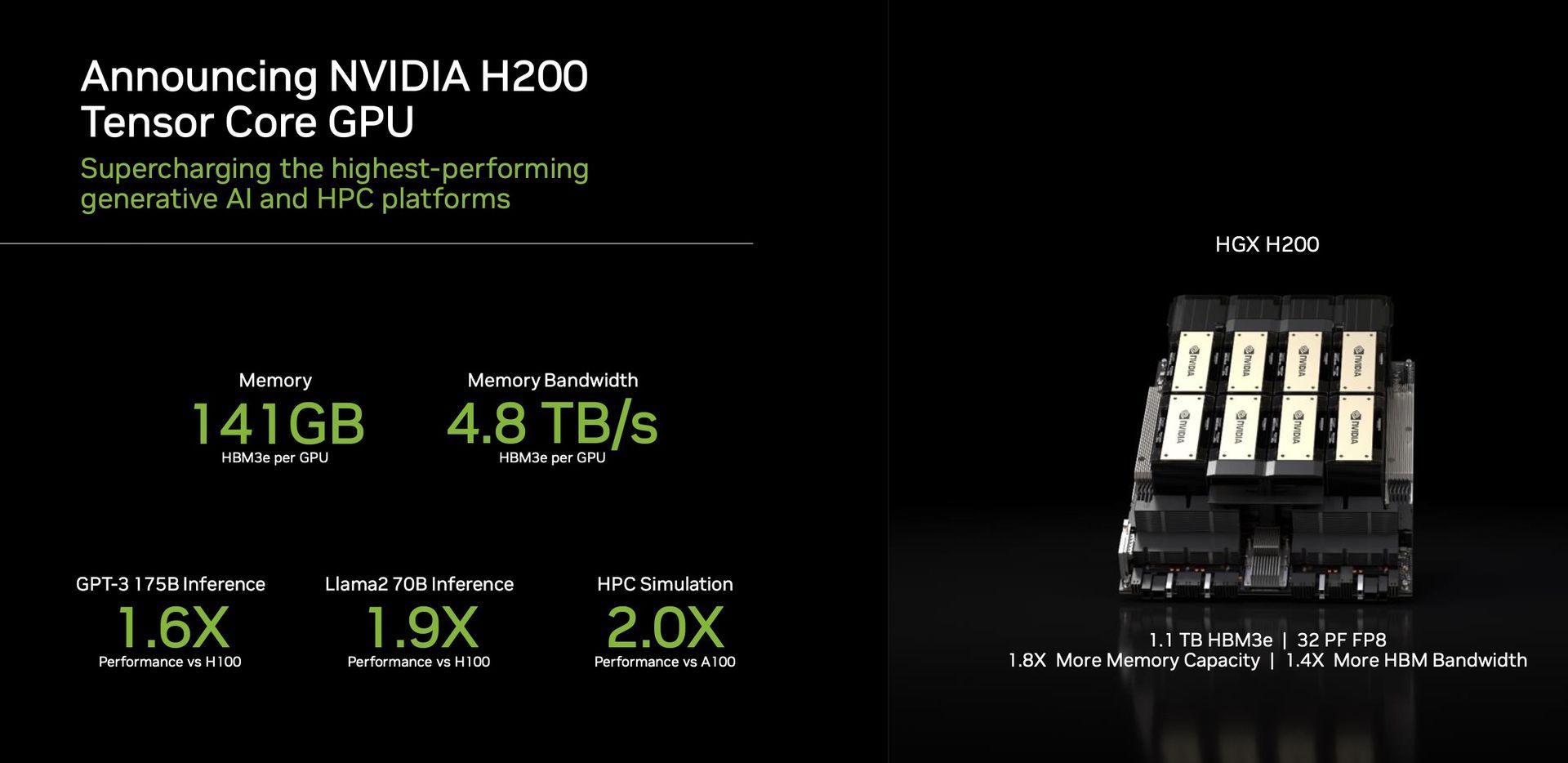

Een opvallend kenmerk van de H200 is het gebruik van HBM3e, de eerste GPU die dit snellere en grotere geheugen biedt. Deze vooruitgang stimuleert de versnelling van generatieve AI en grote taalmodellen, en verlegt tegelijkertijd de grenzen van wetenschappelijk computergebruik voor HPC-workloads. Met HBM3e levert de H200 een indrukwekkende prestatie 141 GB geheugen op een onthutsend 4,8 terabytes per seconde. Dit vertegenwoordigt bijna het dubbele van de capaciteit en 2,4 keer meer bandbreedte vergeleken met zijn voorganger, de NVIDIA A100.

Prestaties en toepassingen

De H200, aangedreven door NVIDIA NVLink en NVSwitch

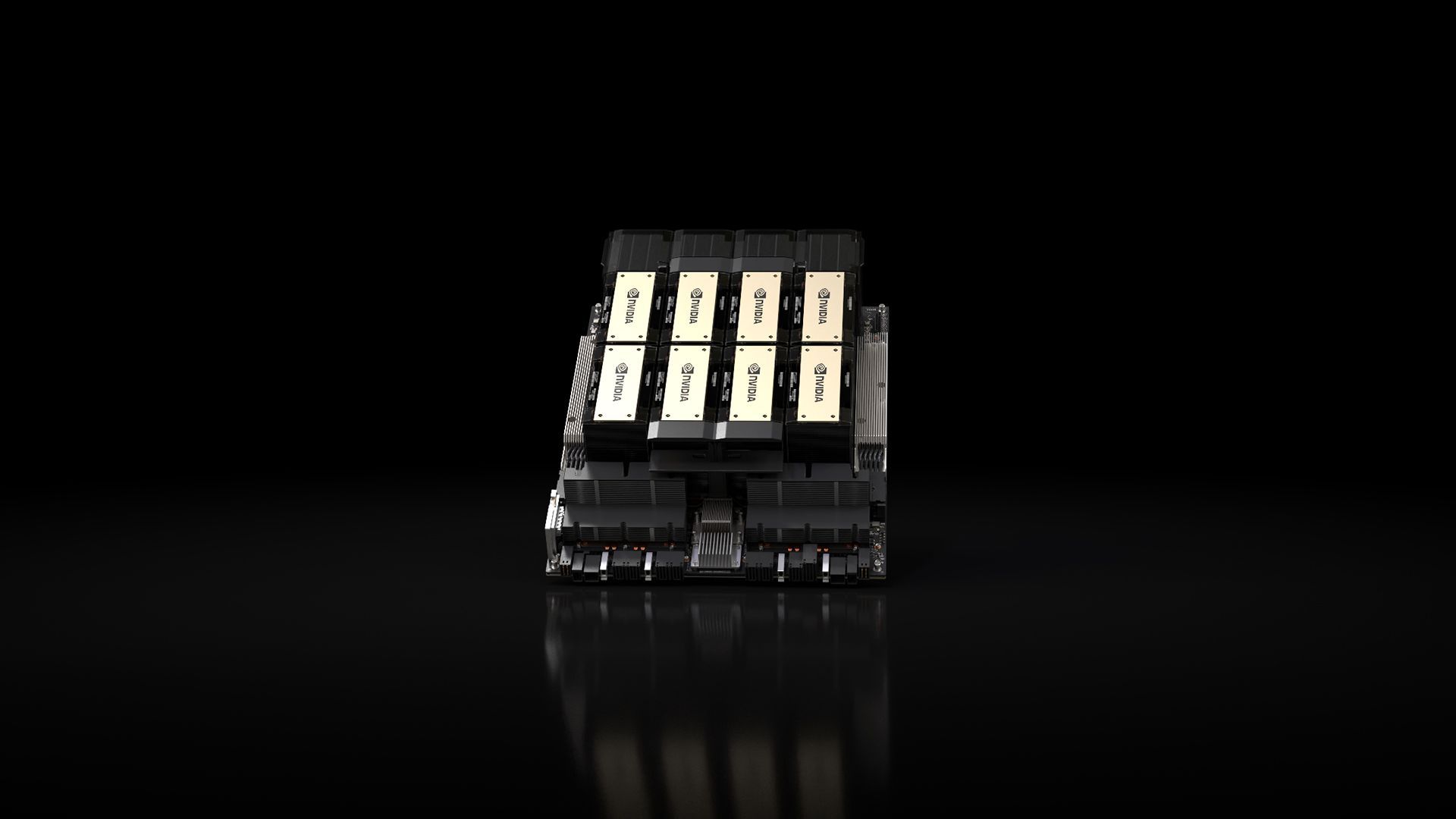

en NVSwitch hogesnelheidsverbindingen, beloften ongeëvenaarde prestaties voor verschillende applicatieworkloads. Dit omvat zijn bekwaamheid in LLM-training (Large Language Model) en gevolgtrekking voor modellen die een kolossaal niveau overtreffen 175 miljard parameters. Een achtvoudig HGX H200 valt op door meer dan genoeg te bieden 32 petaflops van FP8 diep leren rekenen En een totaal geheugen met hoge bandbreedte van 1,1 TB, zorgen voor topprestaties in generatieve AI- en HPC-toepassingen.

hogesnelheidsverbindingen, beloften ongeëvenaarde prestaties voor verschillende applicatieworkloads. Dit omvat zijn bekwaamheid in LLM-training (Large Language Model) en gevolgtrekking voor modellen die een kolossaal niveau overtreffen 175 miljard parameters. Een achtvoudig HGX H200 valt op door meer dan genoeg te bieden 32 petaflops van FP8 diep leren rekenen En een totaal geheugen met hoge bandbreedte van 1,1 TB, zorgen voor topprestaties in generatieve AI- en HPC-toepassingen.

De GPU’s van Nvidia zijn geworden doorslaggevend op het gebied van generatieve AI-modellen, die een cruciale rol spelen in de ontwikkeling en inzet ervan. Ontworpen om enorme parallelle berekeningen uit te voeren die nodig zijn voor het trainen en uitvoeren van deze modellen, blinken de GPU’s van Nvidia uit in taken zoals beeld generatie En natuurlijke taal verwerken. Dankzij de parallelle verwerkingsarchitectuur kunnen deze GPU’s presteren meerdere berekeningen tegelijk, resulterend in een substantiële versnelling van generatieve AI-modelprocessen.

De H200 is een bewijs van de inzet van Nvidia voortdurende innovatie en prestatiesprongen. Voortbouwend op het succes van de Hopper-architectuur, voortdurende softwareverbeteringen, waaronder de recente release van open-sourcebibliotheken zoals NVIDIA TensorRT -LLM, blijven de prestaties van het platform verbeteren. De introductie van NVIDIA H200 belooft verdere sprongen, met verwachtingen van bijna verdubbeling van de inferentiesnelheid op modellen als Llama 2, een LLM met 70 miljard parameters, vergeleken met zijn voorganger, de H100.

-LLM, blijven de prestaties van het platform verbeteren. De introductie van NVIDIA H200 belooft verdere sprongen, met verwachtingen van bijna verdubbeling van de inferentiesnelheid op modellen als Llama 2, een LLM met 70 miljard parameters, vergeleken met zijn voorganger, de H100.

Veelzijdigheid en beschikbaarheid

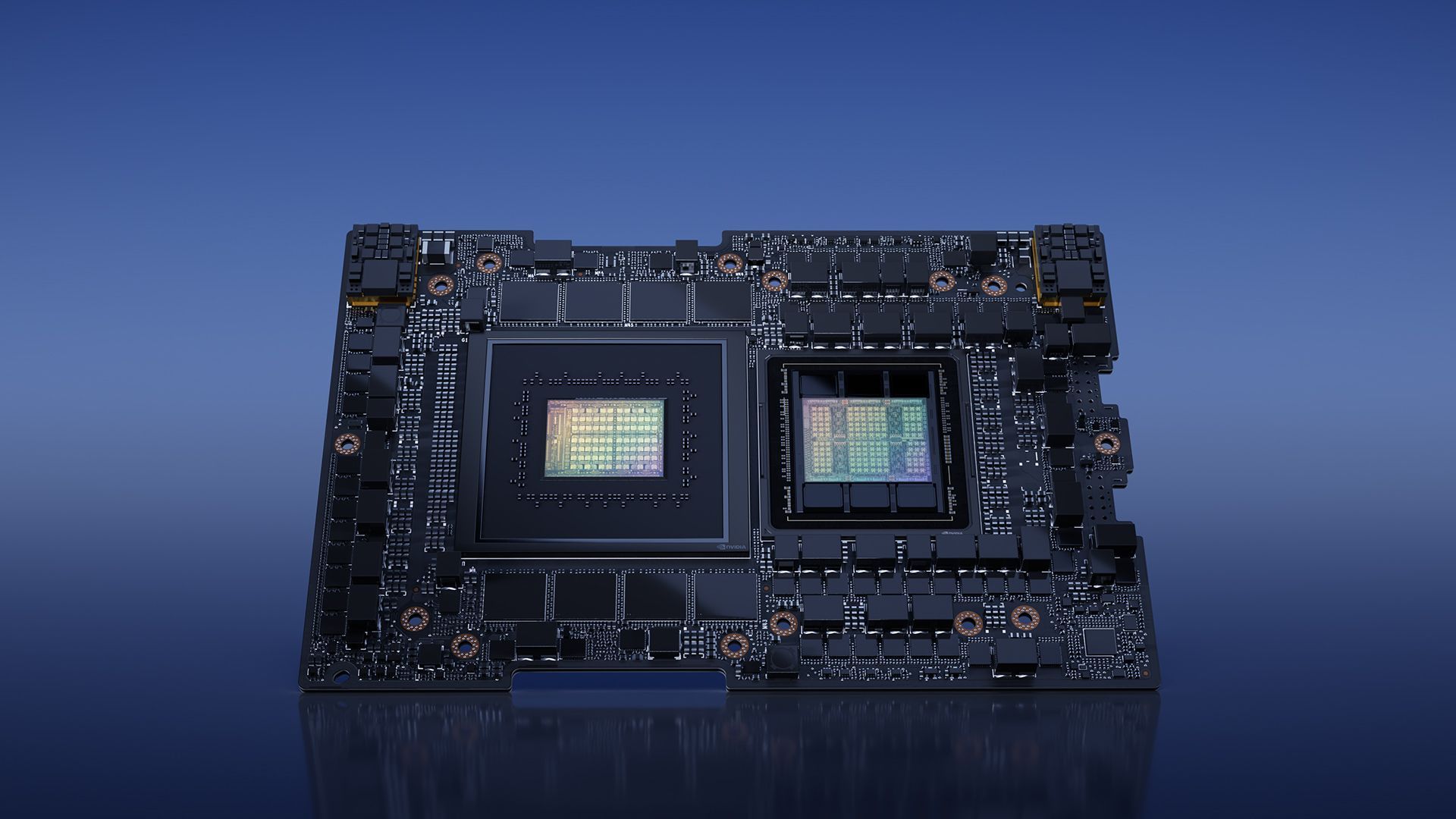

Nvidia zorgt ervoor veelzijdigheid met de H200 en biedt deze in verschillende vormfactoren, zoals NVIDIA HGX H200-serverkaarten met vier- en achtwegconfiguraties. Deze configuraties zijn compatibel met zowel hardware als software van HGX H100-systemen. Bovendien is NVIDIA H200 beschikbaar in de NVIDIA GH200 Grace Hopper Superchip met HBM3e, geschikt voor verschillende datacenteropstellingen, waaronder on-premises, cloud-, hybride cloud- en edge-omgevingen. Het wereldwijde ecosysteem van partnerservermakers kan dat wel naadloos hun bestaande systemen bijwerken met de H200, waardoor een brede toegankelijkheid wordt gegarandeerd.

Superchip met HBM3e, geschikt voor verschillende datacenteropstellingen, waaronder on-premises, cloud-, hybride cloud- en edge-omgevingen. Het wereldwijde ecosysteem van partnerservermakers kan dat wel naadloos hun bestaande systemen bijwerken met de H200, waardoor een brede toegankelijkheid wordt gegarandeerd.

Enthousiastelingen en experts uit de industrie kijken reikhalzend uit naar de release van de HGX H200-systemen, die binnenkort op de markt zullen verschijnen. het tweede kwartaal van 2024. Prominente wereldspelers zoals Amazon-webservices, Google-Cloud, Microsoft Azure, En Oracle Cloud-infrastructuur zijn onder de eerste golf van cloudserviceproviders klaar om volgend jaar op H200 gebaseerde instances te implementeren.

architectuur (Afbeelding tegoed)

architectuur (Afbeelding tegoed)Kortom, de NVIDIA H200, met zijn baanbrekende functies en prestatiemogelijkheden, is klaar voor herdefiniëren het landschap van AI-computing. Zodra de H200 in het tweede kwartaal van 2024 beschikbaar komt, staat hij klaar om ontwikkelaars en ondernemingen over de hele wereld meer mogelijkheden te bieden. het versnellen van de ontwikkeling en inzet van AI-toepassingen van spraak tot hyperscale gevolgtrekking.

Als je geïnteresseerd bent in het toonaangevende technologiebedrijf, lees dan ook ons artikel over hoe Nvidia en AMD werken aan een “arm-based chip”.

Uitgelichte afbeeldingscredits: NVIDIA

Source: NVIDIA H200 wordt met hoge verwachtingen geïntroduceerd op het gebied van AI