Microsoft heeft uitgerold een spannende nieuwe ontwikkeling op het gebied van taalmodellen: de 1-bit LLM. Deze vooruitgang, geïnspireerd door onderzoeksprojecten zoals BitNetmarkeert een opmerkelijke verschuiving in de manier waarop taalmodellen worden geconstrueerd en geoptimaliseerd. De kern van deze innovatie ligt in een opvallend efficiënte methode om modelparameters (of gewichten) weer te geven.met slechts 1,58 bits, in tegenstelling tot de traditionele 16-bits drijvende-komma (FP16) benadering die in eerdere modellen gebruikelijk was.

De eerste in zijn soort 1-bit LLM

Nagesynchroniseerd BitNet LLM b1.58beperkt deze baanbrekende aanpak de potentiële waarden van elk gewicht tot slechts drie opties: -1, 0 of +1. Deze dramatische vermindering van het aantal benodigde bits per parameter vormt de basis voor deze baanbrekende technologie. Verrassend genoeg slaagt BitNet b1.58 erin, ondanks zijn magere bitverbruik prestatiestatistieken leveren die vergelijkbaar zijn met die van traditionele modellen. Dit omvat gebieden zoals verwarring en eindtaakprestaties, allemaal met gebruik van dezelfde omvang en trainingsdatasets.

Wat zijn 1-bit LLM’s?

De generatieve AI-scene evolueert met de dag, en de nieuwste doorbraak in deze dynamische arena is de komst van 1-bit taalleermodellen. Het klinkt misschien verrassend, maar deze ontwikkeling heeft het potentieel om de AI-arena te transformeren door enkele van de belangrijkste hindernissen aan te pakken waarmee LLM’s vandaag de dag worden geconfronteerd:namelijk hun gigantische omvang.

Normaal gesproken worden de gewichten van een Machine Learning-model, of het nu een LLM is of zoiets eenvoudigs als logistieke regressie, opgeslagen met behulp van 32-bits of 16-bits drijvende komma. Deze standaardaanpak is een tweesnijdend zwaard; Hoewel het een hoge nauwkeurigheid in de berekeningen van het model mogelijk maakt, resulteert het ook in de immense omvang van deze modellen.

Deze opgeblazenheid is precies de reden waarom het inzetten van zwaargewichtkampioenen als GPT op lokale systemen of in productieomgevingen een logistieke nachtmerrie wordt. Hun astronomische aantal gewichten, noodzakelijk gemaakt door de precisie van deze drijvende punten, vergroot hun omvang tot onbeheersbare proporties.

In schril contrast met de traditionele modellen, 1-bit LLM’s gebruiken slechts één bit (0 of 1) om gewichtsparameters weer te geven. Deze ogenschijnlijk kleine aanpassing heeft grote gevolgen: het verkleint de totale omvang van de modellen dramatisch, mogelijk met een enorme marge.

Een dergelijke verkleining opent de weg voor de inzet van LLM’s op veel kleinere apparatenwaardoor geavanceerde AI-toepassingen meer worden toegankelijk en haalbaar op een breder scala aan platforms.

Terug naar BitNet LLM b1.58

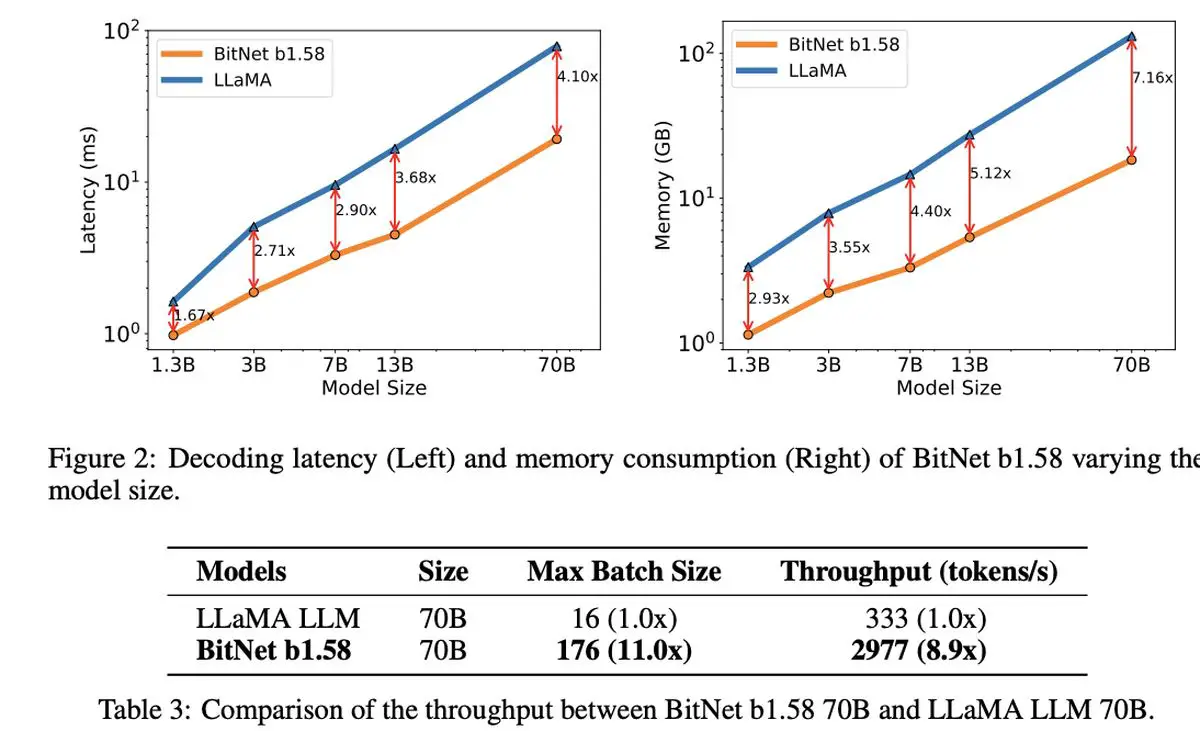

Wat echt opmerkelijk is aan de 1,58-bit LLM is de functionaliteit ervan kosten efficiëntie. Het model blinkt uit in termen van verminderde latentie, lager geheugengebruik, verbeterde doorvoer en lager energieverbruik, en presenteert een duurzame optie in de rekenintensieve wereld van AI.

De 1-bit LLM van Microsoft onderscheidt zich niet alleen door zijn efficiëntie. Het vertegenwoordigt een frisse kijk op het opschalen en trainen van taalmodellen, waarbij topprestaties in evenwicht worden gebracht met economische levensvatbaarheid. Het duidt op het aanbreken van nieuwe computerparadigma’s en de mogelijkheid om gespecialiseerde hardware te creëren die is toegesneden op het uitvoeren van deze slankere, efficiëntere modellen.

De discussie rond BitNet LLM b1.58 opent zich ook intrigerende mogelijkheden om lange reeksen effectiever te beheren in LLM’swat potentiële gebieden voor verder onderzoek suggereert in verliesloze compressietechnieken om de efficiëntie nog verder te verhogen.

In de schaduw van deze opmerkelijke innovatie heeft Microsoft ook furore gemaakt met zijn nieuwste kleine taalmodel, Phi-2. Deze krachtpatser met 2,7 miljard parameters heeft blijk gegeven van uitzonderlijke capaciteiten op het gebied van begrip en redenering, een verder bewijs van de voortdurende inzet van Microsoft om de grenzen van AI-technologie te verleggen. De introductie van de 1-bit LLM, samen met het succes van Phi-2, zou een opwindend tijdperk van innovatie en efficiëntie in de ontwikkeling van taalmodellen benadrukken.

Uitgelichte afbeeldingscredits: Drew Beamer/Unsplash

Source: Microsoft introduceert zijn 1-bit LLM