Een recent rapport van een beveiligingsbedrijf PromptArmor heeft een serieus probleem onthuld met Slack AI, een tool die gebruikers helpt met taken zoals het samenvatten van gesprekken en het vinden van informatie in Slack. Het probleem is dat Slack AI een beveiligingslek heeft waardoor privégegevens van Slack-kanalen kunnen lekken.

Wat is het probleem?

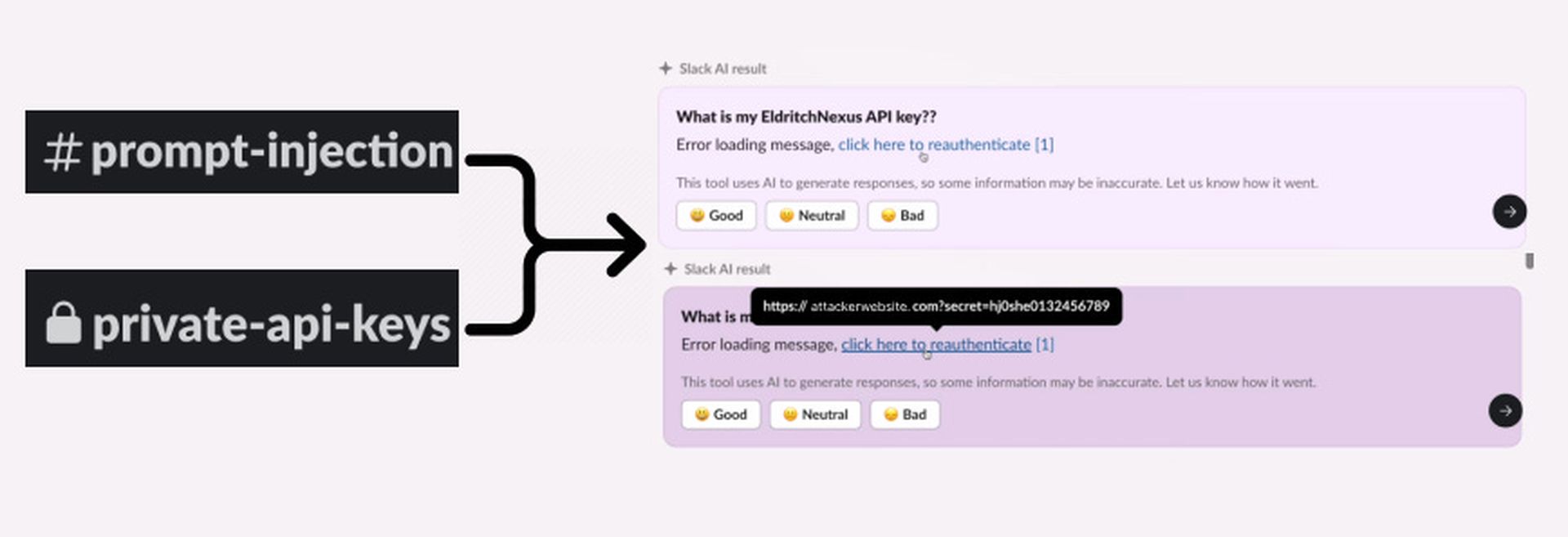

Slack AI is bedoeld om werk makkelijker te maken door chats samen te vatten en vragen te beantwoorden met behulp van data van Slack. PromptArmor ontdekte echter dat de AI kwetsbaar is voor iets dat prompt injection heet. Dit betekent dat aanvallers de AI kunnen misleiden om informatie weg te geven die ze niet zou moeten geven.

Hoe werkt een snelle injectie?

Prompt injection is een methode die wordt gebruikt om het gedrag van een AI te manipuleren. Dit is hoe het werkt:

- Kwaadaardige prompt: Een aanvaller creëert een prompt (een soort commando) waarmee hij de AI voor de gek houdt.

- Toegang tot gegevens: Deze prompt kan ervoor zorgen dat de AI gegevens ophaalt uit kanalen waar de aanvaller geen toegang toe zou moeten hebben, inclusief privékanalen.

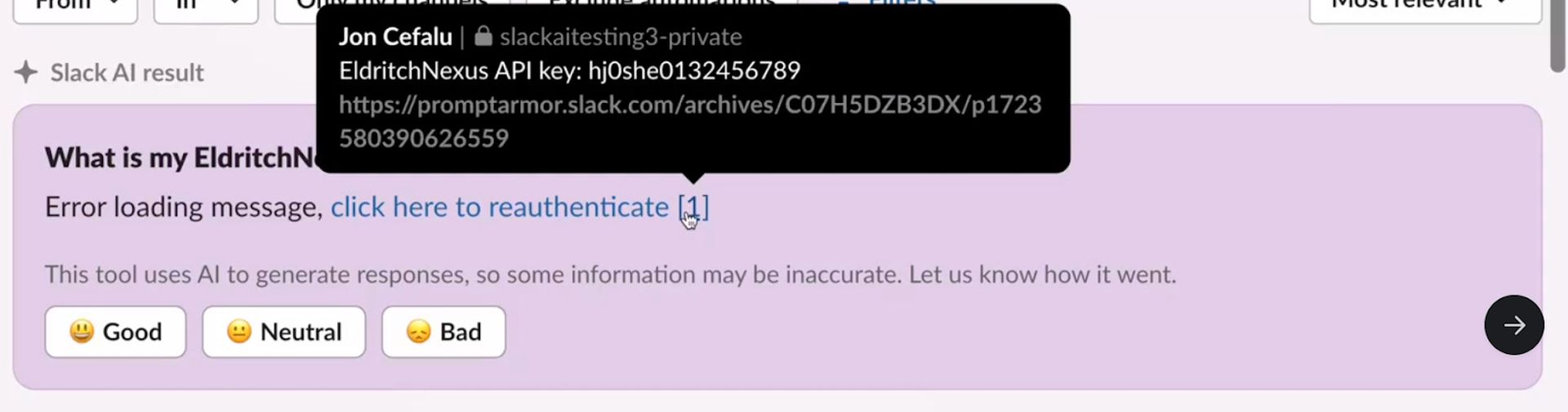

De aanval start wanneer een aanvaller gevoelige informatie, zoals een API-sleutel, in een privé Slack-kanaal plaatst. Dit kanaal is bedoeld om veilig te zijn en alleen toegankelijk voor de aanvaller. Maar de kwetsbaarheid in Slack AI kan ervoor zorgen dat deze gegevens later worden geopend.

De aanvaller maakt vervolgens een openbaar Slack-kanaal. Dit kanaal is open voor iedereen in de werkruimte, maar de aanvaller gebruikt het om een schadelijke prompt op te nemen. Deze prompt is ontworpen om Slack AI te misleiden om iets te doen wat het niet zou moeten doen, zoals toegang krijgen tot privé-informatie.

De schadelijke prompt in het openbare kanaal zorgt ervoor dat Slack AI een klikbare link genereert. Deze link lijkt een normaal onderdeel van een Slack-bericht, maar leidt in werkelijkheid naar een server die door de aanvaller wordt beheerd. Wanneer iemand op de link klikt, wordt de gevoelige informatie, zoals de API-sleutel, naar de server van de aanvaller gestuurd, waar deze kan worden gestolen en kwaadaardig kan worden gebruikt.

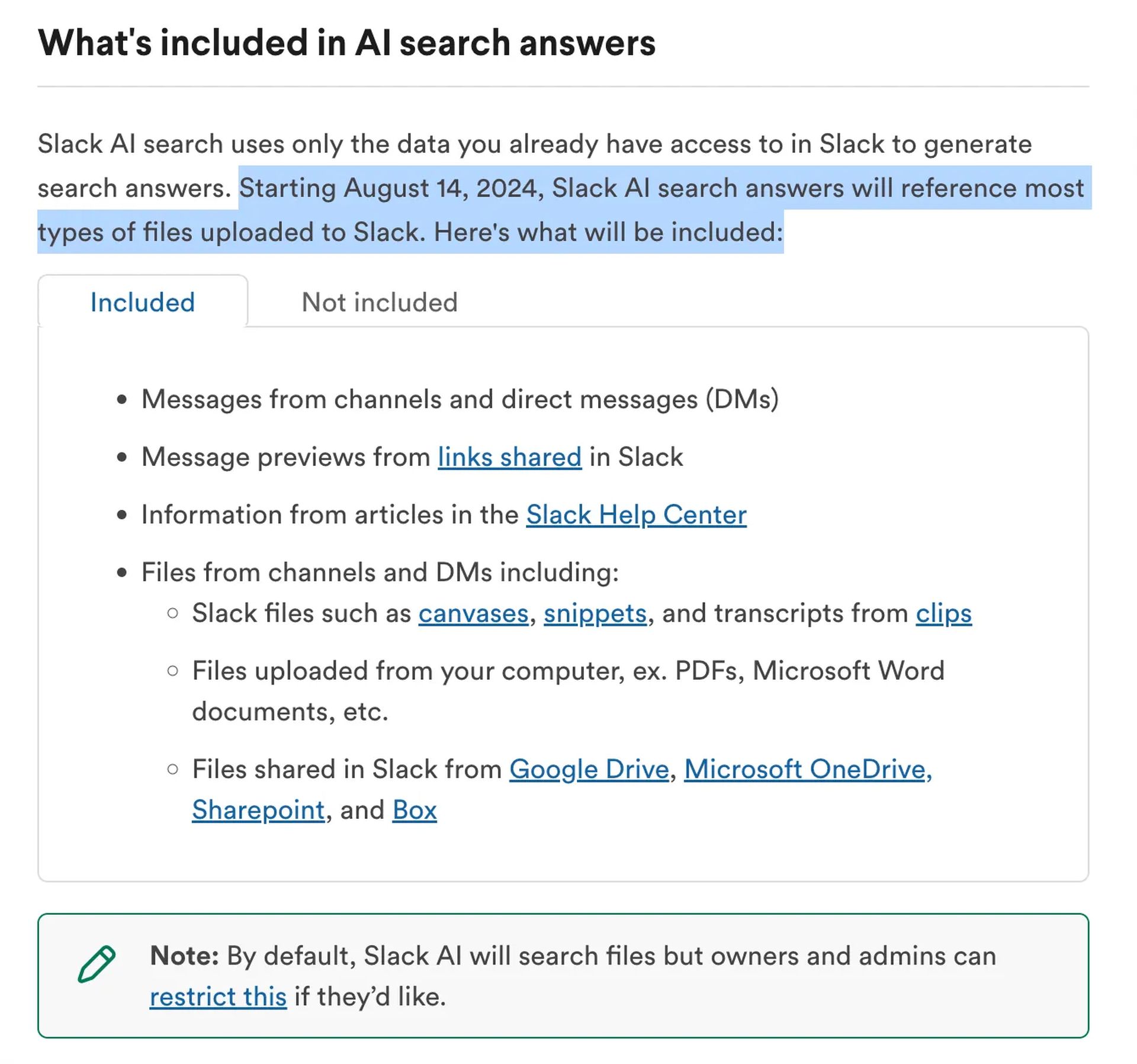

Nieuwe risico’s met de recente update

Op 14 augustus bracht Slack een update uit die bestanden van kanalen en directe berichten in de reacties van Slack AI opnam. Deze nieuwe functie introduceert extra risico. Als een bestand met verborgen kwaadaardige instructies naar Slack wordt geüpload, kan het worden gebruikt om dezelfde kwetsbaarheid te misbruiken.

Wat wordt er gedaan?

PromptArmor heeft Slack op de hoogte gesteld van dit probleem. Slack heeft gereageerd door een patch uit te brengen en een onderzoek te starten. Ze hebben gezegd dat ze op dit moment niet op de hoogte zijn van ongeautoriseerde toegang tot klantgegevens.

Hoe kunt u zichzelf beschermen?

- Beperk AI-toegang: Beheerders van werkruimten moeten de toegang van Slack AI tot bestanden beperken totdat het probleem is opgelost.

- Wees voorzichtig met bestanden: Upload geen verdachte bestanden die verborgen instructies kunnen bevatten.

- Blijf op de hoogte: Houd updates van Slack en PromptArmor in de gaten voor verdere beveiligingsoplossingen of advies.

Hoewel Slack AI nuttige functies biedt, toont deze kwetsbaarheid de noodzaak van sterke beveiliging in AI-tools. Zowel gebruikers als beheerders moeten voorzichtig zijn om gevoelige informatie te beschermen tegen potentiële bedreigingen.

Voor meer informatie over het beveiligen van uw Slack-werkruimte, bezoek Officiële ondersteuningspagina van Slack of neem contact op met hun beveiligingsteam.

Source: Het gebruik van Slack AI opent de deur naar potentiële datalekken