Gemma 2 is net op het 2D AI-toneel verschenen en zorgt voor behoorlijk wat ophef. Dit kleine model bewijst dat goede dingen in kleine verpakkingen zitten en zorgt voor een echt gesprek in de techwereld.

De nieuwste uitvinding van Google, Gemma 2 2B, is een compact taalmodel met slechts 2,6 miljard parameters. Ondanks zijn kleine formaat is deze AI-krachtpatser een partij voor zijn grotere broers en zussen. Gemma 2 2B doet niet alleen wat hij zegt, maar doet wat hij zegt, en evenaart en overtreft zelfs modellen die tien keer zo groot zijn.

Gemma 2 2B’s sprankelende optreden

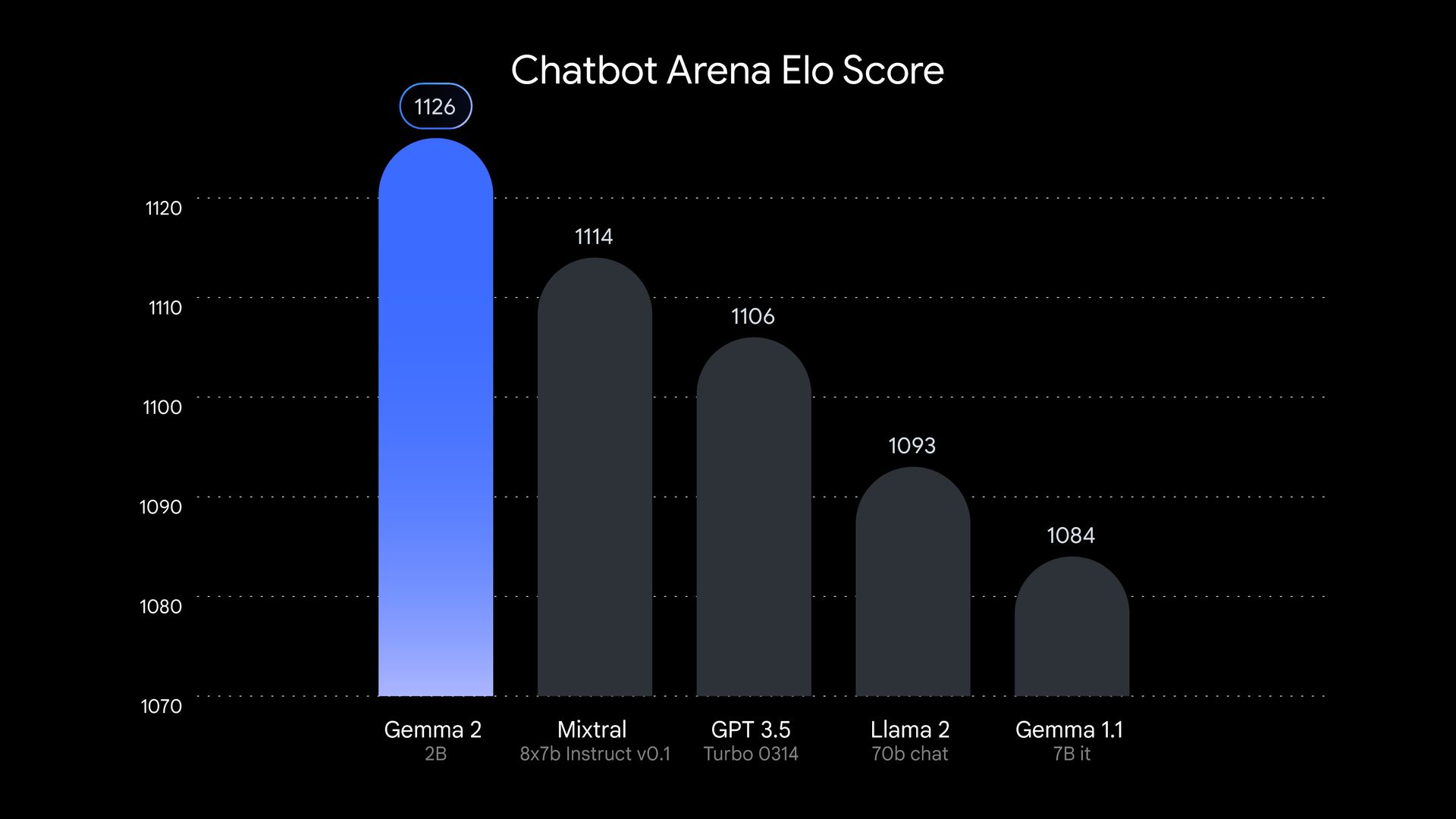

Laten we duidelijk zijn over Gemma 2 2B, dat is niet een andere grote kracht in de grote AI-menigte. Dit model werd getest en kwam er schitterend uit. In tests uitgevoerd door LMSYSeen onafhankelijke AI-onderzoeksgroep, Gemma 2 2B scoorde een indrukwekkende 1130 punten in de evaluatie arena. Dat klopt, dit kleine juweeltje overtrof een aantal grote namen zoals GPT-3.5-Turbo-0613 en Mixtral-8x7B.

Maar de Gemma 2 2B stopt daar niet. Het laat zien dat het ook op andere vlakken slim is. In de MMLU benchmark, die het vermogen van een model test om verschillende onderwerpen te begrijpen en erover te redeneren, scoorde de Gemma 2 2B 56,1 punten. Wat betreft codering scoorde het 36,6 punten in de MBPP test. Deze cijfers vertegenwoordigen een kwantumsprong ten opzichte van zijn voorganger.

Dus hoe deed Google maakt dit kleine wonder? Gemma 2 2B werd getraind op een enorme dataset van 2 biljoen tokens met behulp van Google’s geavanceerde TPU v5e hardware. Dit trainingsproces zorgde ervoor dat het model veel informatie in zijn compacte frame kon verpakken. Gemma 2 2B is ook meertalig, waardoor zijn potentiële use cases wereldwijd worden uitgebreid. Dit maakt het een veelzijdige tool voor ontwikkelaars en onderzoekers die aan internationale projecten werken.

Het succes van Gemma 2 2B daagt het idee uit dat groter altijd beter is in AI. De indrukwekkende prestaties laten zien dat met de juiste trainingstechnieken, efficiënte architecturen en hoogwaardige data, kleinere modellen ver boven hun gewichtsklasse kunnen uitstijgen. Deze ontwikkeling zou de focus in AI-onderzoek kunnen verschuiven van het creëren van grotere modellen naar het verbeteren van kleinere, efficiëntere modellen. Dit is een verandering die verstrekkende gevolgen kan hebben voor het veld en AI mogelijk toegankelijker en milieuvriendelijker kan maken.

De toekomst van AI polijsten

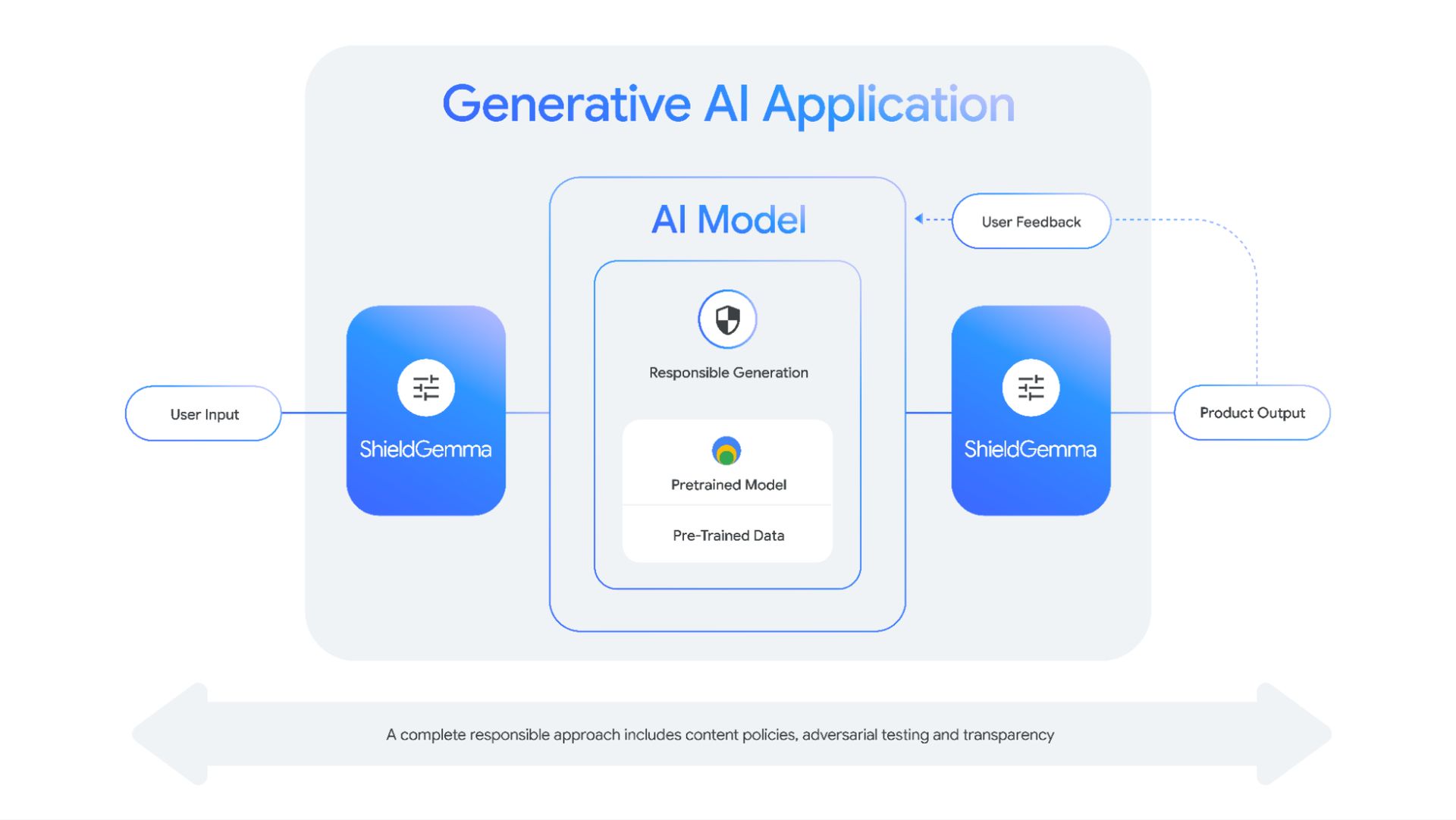

Gemma 2 2D vertegenwoordigt een groeiende trend in AI richting efficiëntere modellen. Naarmate de zorgen over de impact op het milieu en de toegankelijkheid van grote taalmodellen toenemen, zoeken technologiebedrijven naar manieren om kleinere systemen te creëren die op alledaagse hardware kunnen draaien.

Het succes van Gemma 2 2D benadrukt ook het belang van modelcompressie- en distillatietechnieken. Door kennis van grotere modellen effectief te condenseren tot kleinere, kunnen onderzoekers toegankelijkere AI-tools creëren zonder dat dit ten koste gaat van de prestaties.

Deze aanpak vermindert niet alleen de rekenkracht die nodig is om deze modellen uit te voeren, maar pakt ook de zorgen aan over de milieu-impact van het trainen en uitvoeren van grote AI-systemen. Dit is een win-winsituatie die de toekomst van AI-ontwikkeling zou kunnen vormgeven.

Gemma 2 2B bewijst dat het bij AI niet om de grootte gaat, maar om hoe je het gebruikt. Dit kleine maar krachtige model daagt onze aannames over AI uit en baant de weg voor een nieuwe generatie efficiënte, krachtige en toegankelijke AI-systemen. Het is duidelijk dat dit kleine juweeltje zal schitteren in de wereld van AI.

Bron van de hoofdafbeelding: Google

Source: Grootte maakt niet uit: Gemma 2 2B bewijst dat AI klein kan denken