De Megalopolis-trailer is in de problemen gekomen nadat bleek dat sommige recensiecitaten nep waren en door AI waren gegenereerd. Eddie Egan, die verantwoordelijk was voor de marketing van de trailer, is vanwege deze puinhoop uit zijn functie ontheven.

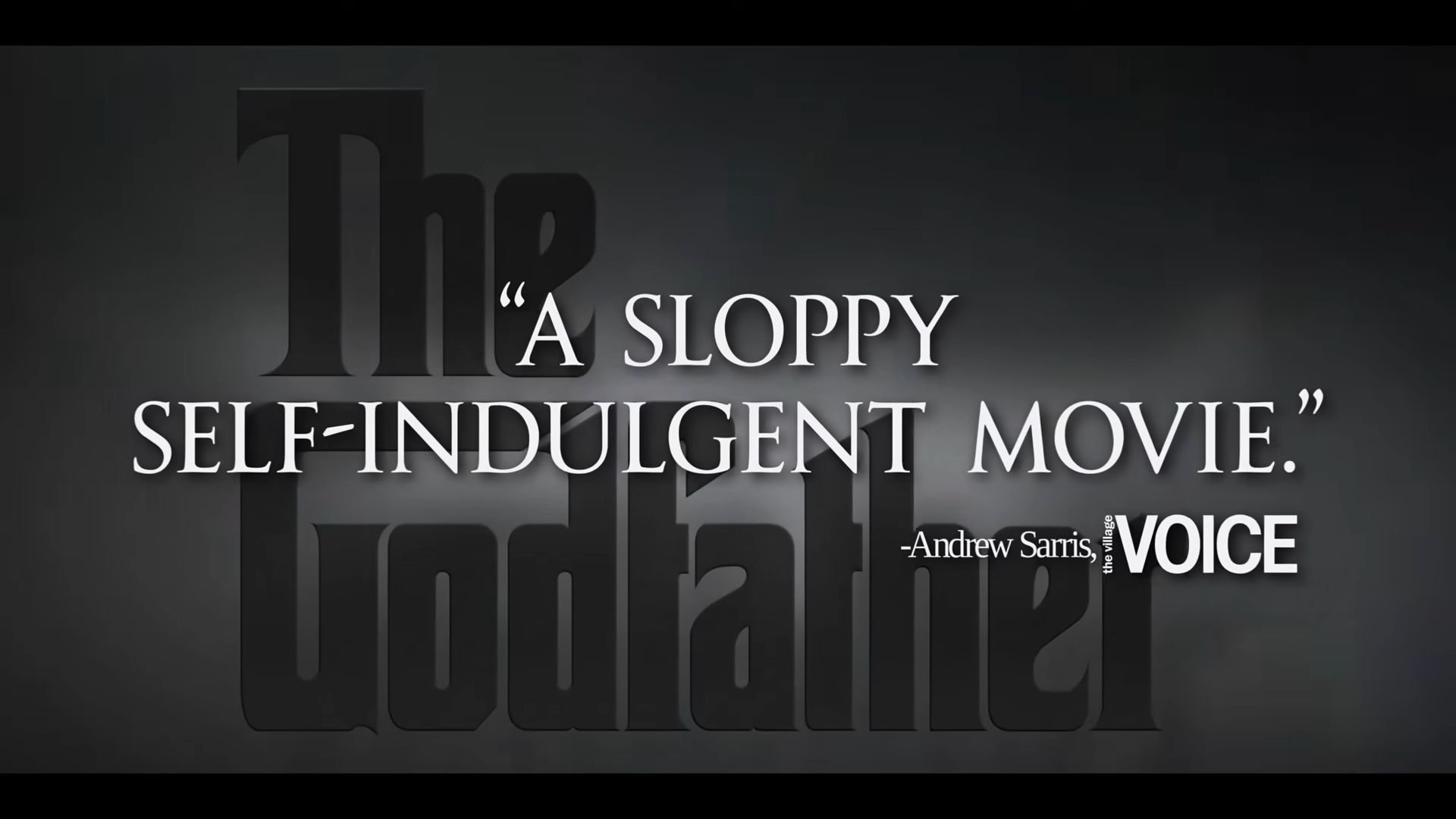

De trailer bevatte verzonnen recensies die kritiek leverden op de klassieke films van Francis Ford Coppola. Er werd ten onrechte beweerd dat “The Godfather” een “slordige, zelfingenomen film” was en dat “Apocalypse Now” een “epos was van troep”. In werkelijkheid waren de originele recensies positief en prezen ze de films.

Deze situatie benadrukt een groeiend probleem met AI: het kan hallucineren. Dit is niet alleen een probleem voor filmtrailers; AI-fouten hebben ook juridische documenten en rechtszaken beïnvloed. Zo diende de advocaat van Michael Cohen nep-rechtszaken in en maakten de advocaten van een Colombiaanse luchtvaartmaatschappij soortgelijke fouten. Zelfs rapper Pras Michél verloor een rechtszaak omdat zijn advocaat een door AI gegenereerd argument gebruikte.

Wat zijn AI-hallucinaties? Het Megalopolis-trailerschandaal laat zien hoe ze werken

AI-hallucinaties treden op wanneer kunstmatige intelligentie informatie genereert die overtuigend klinkt, maar in werkelijkheid vals of misleidend is. Het schandaal rond de trailer van “Megalopolis” bracht deze term in de schijnwerpers.

In dit geval bevatte de trailer neprecensiecitaten over de films van Francis Ford Coppola, waarin werd beweerd dat “The Godfather” “slordig” was en “Apocalypse Now” “een episch stuk troep”. AI creëerde deze citaten, maar ze kwamen niet overeen met de daadwerkelijke positieve recensies van deze films. De AI “hallucineerde” deze citaten en produceerde geloofwaardige maar valse verklaringen.

AI-hallucinaties ontstaan omdat de technologie tekst kan genereren op basis van patronen die het uit data heeft geleerd, maar de inhoud niet echt begrijpt. Het kan feiten vermengen, fouten maken of dingen helemaal verzinnen, wat gebeurde met de misleidende recensies in de trailer.

Dit incident benadrukt de risico’s van het vertrouwen op AI zonder de juiste controles. Net als in de zaak “Megalopolis”, waar valse citaten ernstige gevolgen hadden voor de betrokkenen, kunnen AI-hallucinaties verwarring en schade veroorzaken als ze niet zorgvuldig worden beheerd. Het is een herinnering dat AI weliswaar krachtig kan zijn, maar dat het cruciaal is om de output ervan te verifiëren om misleidende informatie te voorkomen.

Bron van de hoofdafbeelding: IMDb-bestand

Source: Als je AI op deze manier gebruikt, verlies je je baan