De Meta Llama 3.1 405B is officieel aangekondigd en heeft naam gemaakt voordat de AI-mogelijkheden überhaupt zijn gelanceerd. Dit geavanceerde model, ontwikkeld door Meta, biedt ongekende flexibiliteit, controle en prestaties om te concurreren met de beste closed-source AI-modellen.

Gisteren kregen sommige gebruikers een voorproefje van het potentieel en vandaag hebben we officiële benchmarktests die de indrukwekkende mogelijkheden benadrukken. U kunt hier ook meer lezen over de onthullingen van gisteren.

Wat is Meta Llama 3.1 405B?

Vandaag leren we alles wat er te weten valt over Meta Llama 3.1 405B. Llama 3.1 405B is een open-source AI die uitblinkt in een verscheidenheid aan taken zoals algemene kennis, navigeerbaarheid, wiskunde, gereedschapsgebruik en meertalige vertaling, terwijl de mid-level 70B en min-level 8B versies ook uitblinken in hun respectievelijke klassen. Met een contextlengte van 128K en ondersteuning voor acht talen, is dit model ontworpen om complexe en diverse applicaties aan te kunnen.

Getraind op meer dan 15 biljoen tokens met behulp van meer dan 16 duizend H100 GPU’s, onderscheidt Llama 3.1 405B zich als een van de krachtigste en meest capabele AI-modellen die beschikbaar zijn. Er is veel energie gestoken in deze AI. Nu kunnen we technisch worden.

Belangrijkste kenmerken van Meta Llama 3.1 405B

Meta Lama 3.1 405B biedt verschillende geavanceerde functies:

- Uitgebreide contextlengte: Ondersteunt een contextlengte tot 128K, ideaal voor het samenvatten van lange teksten en complexe gesprekken.

- Meertalige mogelijkheden: Ondersteunt meerdere talen, waardoor het veelzijdig is voor wereldwijde toepassingen.

- Geavanceerd gereedschapsgebruik: Kan worden geïntegreerd met verschillende tools voor verbeterde functionaliteit.

- Synthetische datageneratie: Maakt het mogelijk om synthetische gegevens te creëren voor het verbeteren en trainen van kleinere modellen.

- Model distillatie: Maakt het mogelijk om grote modellen om te zetten in kleinere, efficiëntere versies.

Meta is een partnerschap aangegaan met meer dan 25 bedrijven om Meta Lama 3.1 405B gemakkelijker te gebruiken. Deze ecosysteemondersteuning maakt het haalbaarder voor ontwikkelaars en onderzoekers om met dit krachtige model te werken, zelfs zonder toegang tot enorme rekenbronnen.

Hoe Meta Llama 3.1 405B te gebruiken

Om Meta Llama 3.1 405B te gaan gebruiken, volgt u deze stappen:

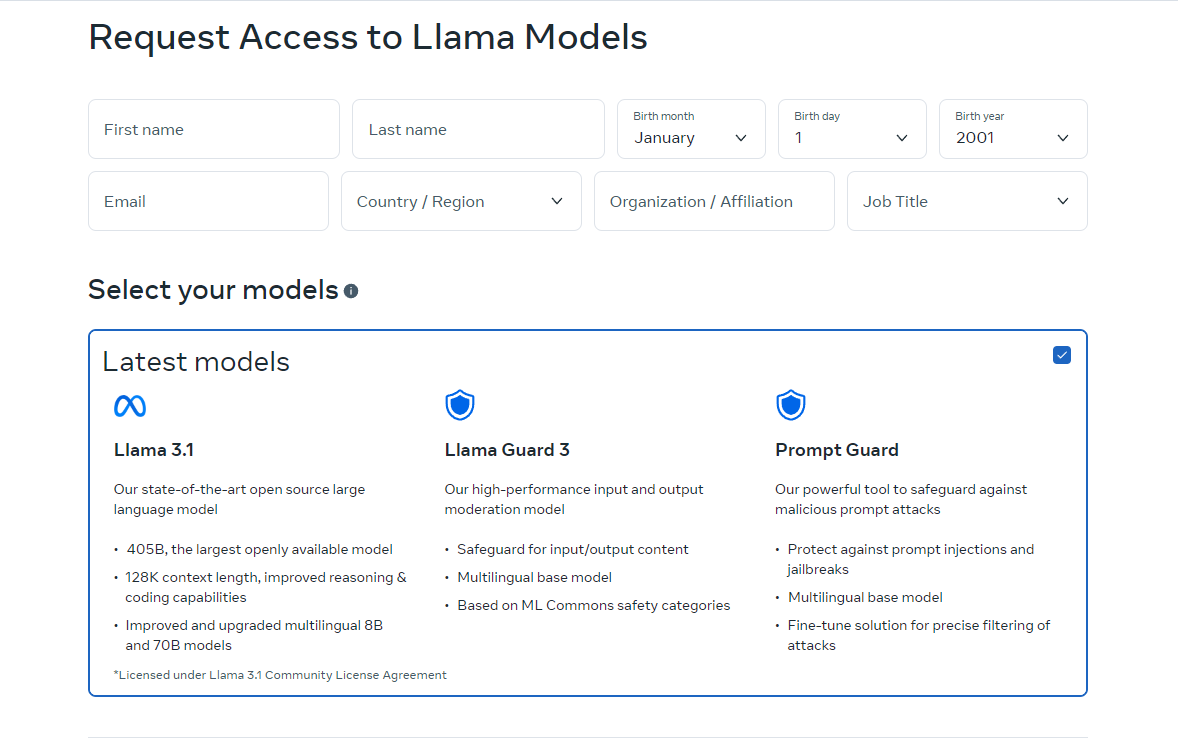

- Toegang tot het model: Bezoek lama.meta.com of Knuffelend gezicht naar downloaden het model. Deze platforms bieden de benodigde bestanden en documentatie om aan de slag te gaan.

- Stel uw omgeving in: Zorg ervoor dat u een geschikte omgeving hebt om het model te draaien. Dit omvat de vereiste hardware, zoals GPU’s, en softwareafhankelijkheden zoals Python en PyTorch.

- Laad het model: Gebruik de meegeleverde codefragmenten en richtlijnen om het model in uw applicatie te laden. Meta biedt gedetailleerde instructies om u te helpen Llama 3.1 405B in uw projecten te integreren.

- Afleiding uitvoeren: Begin met het gebruiken van het model voor realtime- of batch-inferentie. U kunt het model vragen stellen, tekst genereren of vertalingen uitvoeren met behulp van de krachtige mogelijkheden.

- Fijnafstemmen voor specifieke taken: Indien nodig kunt u het model voor specifieke toepassingen finetunen met behulp van supervised fine-tuning-technieken. Meta biedt bronnen en voorbeelden om u door dit proces te leiden.

De online versie van Llama is momenteel alleen beschikbaar in bepaalde landen. U kunt het echter ook lokaal gebruiken door de open-sourcecodes te downloaden. Downloadinstructies zijn beschikbaar op de sites waar we u naartoe verwijzen. U kunt Meta Llama 3.1 405B ook gebruiken via Grog.

Hoe Meta Llama 3.1 405B op Groq te gebruiken

Meta Llama 3.1 405B, het grootste en meest capabele open funderingsmodel tot nu toe, is nu beschikbaar op Groq. Deze gids leidt u door de stappen om aan de slag te gaan met Meta Llama 3.1 405B op Groq.

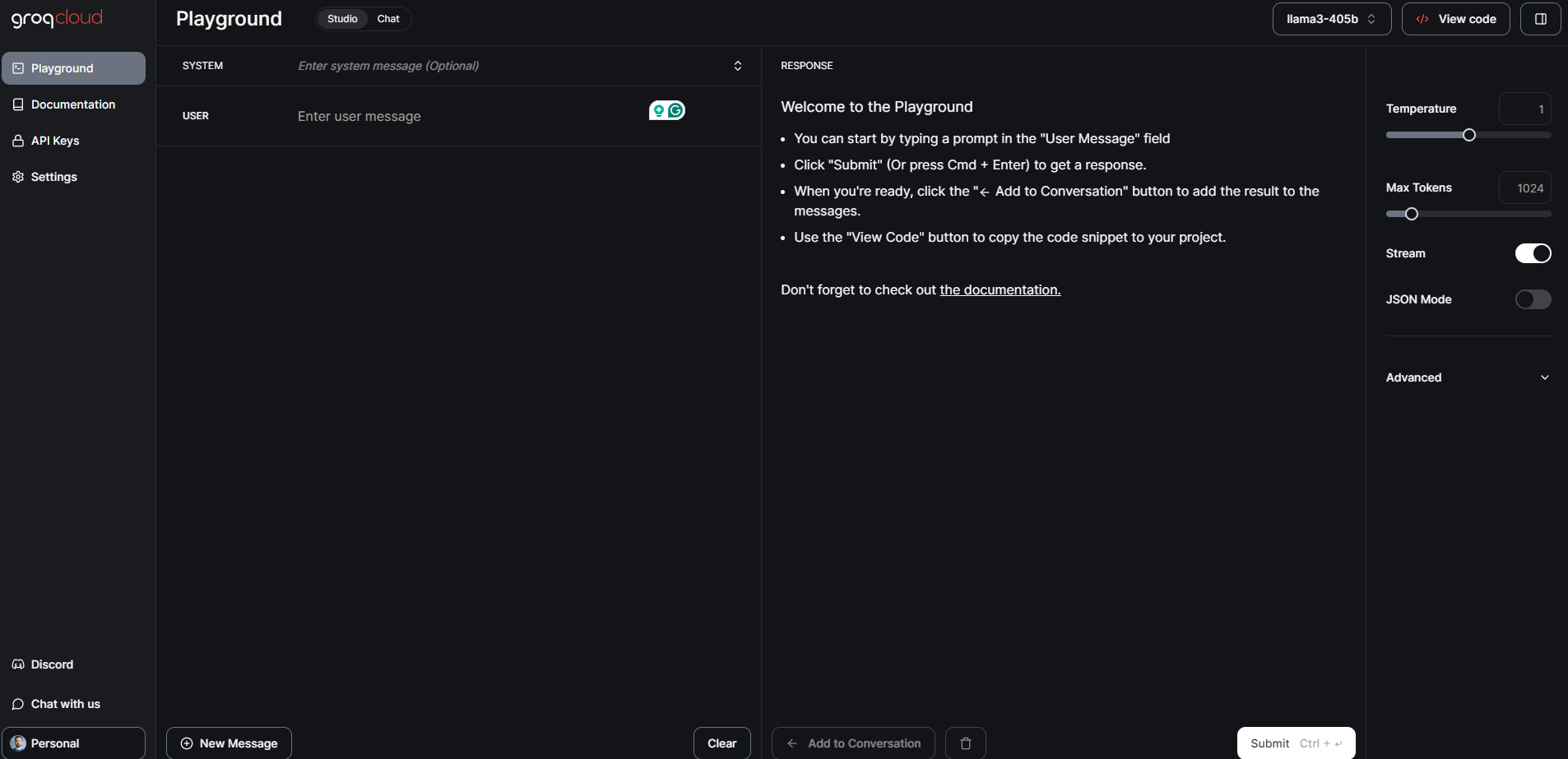

Stap 1: GroqCloud Dev Console

- Registreer Log in: Bezoek de GroqCloud Dev-console en meld u aan of log in op uw account.

- Vind Meta Llama 3.1-modellen: Navigeer naar de modellen sectie en zoek naar Meta Llama 3.1 405B. Je vindt hier ook de 70B en 8B Instruct modellen beschikbaar.

- Een API-sleutel verkrijgen: Verkrijg een gratis Groq API-sleutel van de console. Met deze sleutel kunt u met het model communiceren.

GroqChat

Voor algemene openbare toegang kunt u GroqChat gebruiken:

- Bezoek GroqChat: Ga naar GroqChat om direct met Meta Llama 3.1 405B te communiceren.

- Ontdek functies: Test de mogelijkheden van het model in realtime, zoals het genereren van tekst, vertalingen of het beantwoorden van vragen.

Stap 2: Uw omgeving instellen

Hardware- en softwarevereisten

- Hardware: Zorg ervoor dat u over de juiste hardware beschikt, bij voorkeur GPU’s, om aan de vereisten van het model te voldoen.

- Software: Installeer de benodigde software-afhankelijkheden zoals Python en PyTorch. Gedetailleerde installatie-instructies vindt u op de GroqCloud Dev Console.

Omgevingsconfiguratie

- API-integratieVervang uw bestaande industriestandaard API-sleutel door de Groq API-sleutel.

- Basis-URL instellen: Configureer uw applicatie om de basis-URL van Groq te gebruiken voor API-aanvragen.

Stap 3: Het model laden en uitvoeren

Het model laden

- Codefragmenten: Gebruik de meegeleverde codefragmenten op de GroqCloud Dev Console om Meta Llama 3.1 405B in uw toepassing te laden.

- Initialisatie: Initialiseer het model met de API-sleutel en stel alle benodigde parameters in voor uw specifieke gebruiksgeval.

Uitvoeren van inferentie

- Realtime-inferentie: Start met het uitvoeren van realtime-inferentie door query’s naar het model te sturen en reacties te ontvangen.

- Batchverwerking: Voor grotere taken kunt u batchverwerking gebruiken om meerdere query’s tegelijkertijd te verwerken.

Stap 4: Fine-tuning voor specifieke taken

- Trainingsdata: Bereid uw dataset voor op de specifieke toepassing waarvoor u het model wilt verfijnen.

- Fijnafstemmingsproces: Volg de gedetailleerde instructies van Meta en Groq om het model te verfijnen met behulp van begeleide technieken.

- Geldigmaking: Valideer het verfijnde model om er zeker van te zijn dat het voldoet aan de gewenste prestatie-criteria.

Meta Llama 3.1 405B: Benchmarktests en prestaties

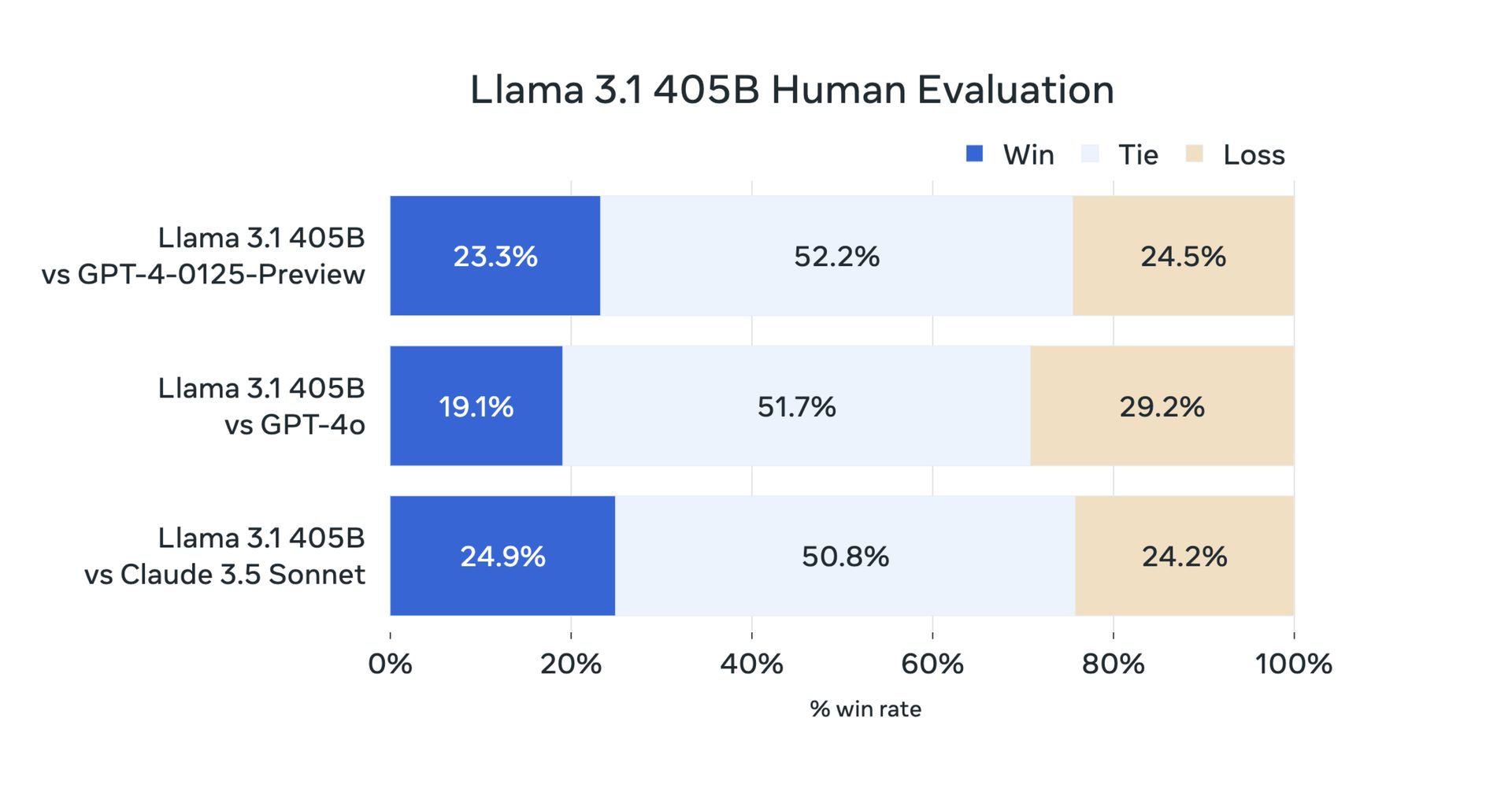

Gisteren hebben gebruikers hun tests uitgevoerd vanwege de open-source aard ervan. Maar nu hebben officiële benchmarktests bevestigd dat Meta Llama 3.1 405B uitzonderlijk goed presteert op verschillende taken. Het model is geëvalueerd op meer dan 150 benchmarkdatasets en vergeleken met toonaangevende modellen zoals GPT-4 en Claude 3.5 Sonnet. De resultaten laten zien dat Llama 3.1 405B kan concurreren met deze topmodellen en hoogwaardige prestaties levert in real-world scenario’s.

Allereerst zijn hier de benchmarks van de Llama 3.1 8B en Llama 3.1 70B:

| Categorie | Maatstaf | Lama 3.1 8B | Gemma 2 9B HET | Mistral 7B Instrueren | Lama 3.1 70B | Mixtral 8x22B Instructie | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Algemeen | MMLU (0-schoten, CoT) | 73.0 | 72.3 | 60.5 | 86.0 | 79.9 | 69,8 |

| Algemeen | MMLU PRO (5-schoten, CoT) | 48.3 | – | 36.9 | 66.4 | 56.3 | 49.2 |

| Algemeen | IFE-waarde | 80.4 | 73.6 | 57.6 | 87.5 | 72.7 | 69.9 |

| Code | HumanEval (0-shot) | 72.6 | 54.3 | 40.2 | 80,5 | 75.6 | 68.0 |

| Code | MBPP EvalPlus (basis) (0-shot) | 72.8 | 71.7 | 49.5 | 86.0 | 78.6 | 82.0 |

| Wiskunde | GSM8K (8-opname, CoT) | 84.5 | 76.7 | 53.2 | 95.1 | 88.2 | 81.6 |

| Wiskunde | WISKUNDE (0-schot, CoT) | 51.9 | 44.3 | 13.0 | 68.0 | 54.1 | 43.1 |

| Redenering | ARC-uitdaging (0-shot) | 83.4 | 87.6 | 74.2 | 94.8 | 88.7 | 83.7 |

| Redenering | GPQA (0-shot, CoT) | 32.8 | – | 28.8 | 46.7 | 33.3 | 30.8 |

| Gereedschapsgebruik | BFCL | 76.1 | – | 60.4 | 84.8 | – | 85.9 |

| Gereedschapsgebruik | Verbinding | 38.5 | 30.0 | 24.7 | 56.7 | 48.5 | 37.2 |

| Lange context | ZeroSCROLLS/KwALITEIT | 81.0 | – | – | 90,5 | – | – |

| Lange context | InfiniteBench/En.MC | 65.1 | – | – | 78.2 | – | – |

| Lange context | NIH/Multi-naald | 98,8 | – | – | 97,5 | – | – |

| Meertalig | Meertalige MGSM (0-shot) | 68.9 | 53.2 | 29.9 | 86.9 | 71.1 | 51.4 |

En er is een Meta Llama 3.1 405B benchmarks:

| Categorie | Maatstaf | Lama 3.1 405B | Nemotron 4 340B Instructie | GPT-4 (0125) | GPT-4 Omni | Claude 3.5 Sonnet |

|---|---|---|---|---|---|---|

| Algemeen | MMLU (0-schoten, CoT) | 88.6 | 78,7 (niet-CoT) | 85.4 | 88.7 | 88.3 |

| Algemeen | MMLU PRO (5-schoten, CoT) | 73.3 | 62.7 | 64.8 | 74.0 | 77.0 |

| Algemeen | IFE-waarde | 88.6 | 85.1 | 84.3 | 85.6 | 88.0 |

| Code | HumanEval (0-shot) | 89.0 | 73.2 | 86.6 | 90.2 | 92.0 |

| Code | MBPP EvalPlus (basis) (0-shot) | 88.6 | 72.8 | 83.6 | 87.8 | 90,5 |

| Wiskunde | GSM8K (8-opname, CoT) | 96.8 | 92.3 (0-schoten) | 94.2 | 96.1 | 96,4 (0-schoten) |

| Wiskunde | WISKUNDE (0-schot, CoT) | 73.8 | 41.1 | 64.5 | 76.6 | 71.1 |

| Redenering | ARC-uitdaging (0-shot) | 96.9 | 94.6 | 96.4 | 96.7 | 96.7 |

| Redenering | GPQA (0-shot, CoT) | 51.1 | – | 41.4 | 53.6 | 59.4 |

| Gereedschapsgebruik | BFCL | 88,5 | 86.5 | 88.3 | 80,5 | 90.2 |

| Gereedschapsgebruik | Verbinding | 58.7 | – | 50.3 | 56.1 | 45.7 |

| Lange context | ZeroSCROLLS/KwALITEIT | 95.2 | – | – | 90,5 | 90,5 |

| Lange context | InfiniteBench/En.MC | 83.4 | – | 72.1 | 82.5 | – |

| Lange context | NIH/Multi-naald | 98.1 | – | 100.0 | 100.0 | 90.8 |

| Meertalig | Meertalige MGSM (0-shot) | 91.6 | – | 85.9 | 90,5 | 91.6 |

Meta Llama 3.1 405B vertegenwoordigt vooruitgang in open-source AI door ontwikkelaars en onderzoekers een krachtige tool te bieden voor een verscheidenheid aan toepassingen. Met zijn geavanceerde functies, robuuste ecosysteem en toewijding aan verantwoorde ontwikkeling hopen we dat Llama 3.1 405B innovaties zal brengen naar de 70B en 8B AI-community’s. Hier is alles wat we voor u hebben voorbereid.

Bron van de hoofdafbeelding: Meta-AI

Source: Alles wat u moet weten over Meta Llama 3.1 405B